【加強規範】私隱公署推AI模範框架 助機構合法應用AI技術

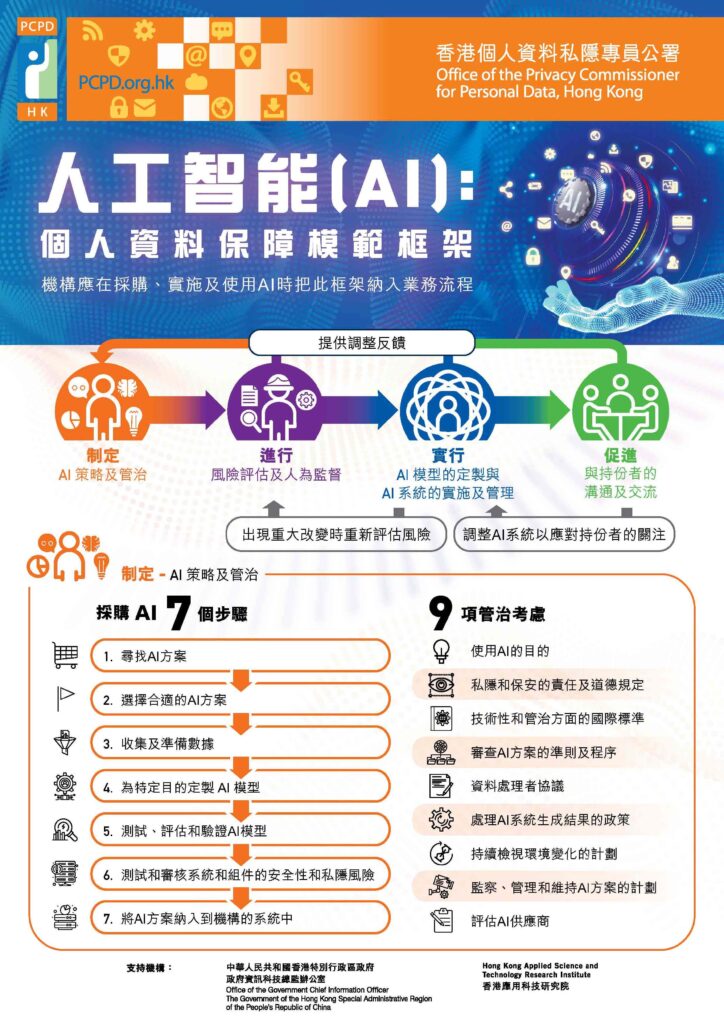

人工智能(AI)時代來臨,不少企業開始進行數碼轉型,AI 應用日漸普及,與此同時衍生出不少私隱風險。為應對其對個人資料私隱帶來的挑戰,個人資料私隱專員公署發布《人工智能(AI):個人資料保障模範框架》,並涵蓋 4 大範疇,提出建議措施。

個人資料私隱專員鍾麗玲指,香港企業多透過生成式 AI 應用於聊天機械人,或文字辨識工具,但機構使用個人資料訓練 AI 時,未必有意識確保個人資料私隱安全。而《模範框架》參照了國際使用人工智能的常規,旨在協助機構在採購、實施及使用 AI 時遵從《個人資料(私隱)條例》,並有助規範相關行業,促進 AI 在香港的健康發展。

框架就以下四個範疇提出建議措施:

- 制定 AI 策略及管治架構:制定機構的 AI 策略及採購 AI 方案的管治考慮、成立 AI 管治委員會(或類似組織)及為員工提供 AI 相關的培訓;

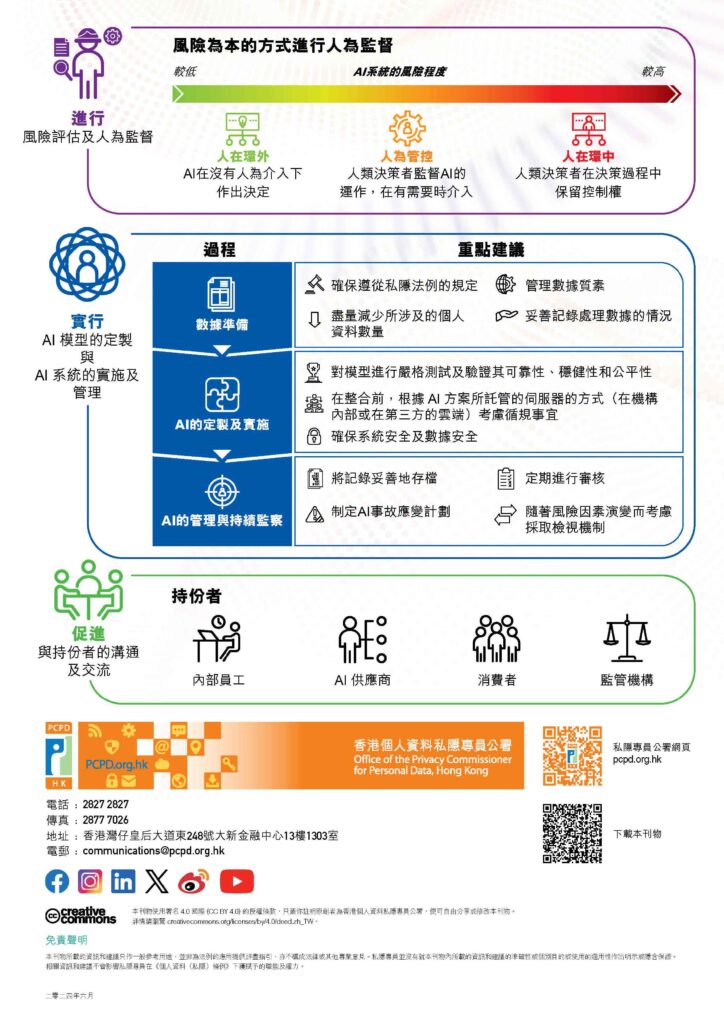

- 進行風險評估及人為監督:進行全面風險評估,建立一套風險管理機制,採取「風險為本」的管理方式,並視乎 AI 的風險高低而採取相應的風險緩減措施,包括決定人為監督的程度;

- 實行 AI 模型的定製與 AI 系統的實施及管理:為定製及/或使用 AI 模型準備及管理數據,包括個人資料、在定製及實施有關 AI 系統的過程中測試及驗證 AI 模型、確保 AI 的系統安全及數據安全,以及對 AI 系統進行管理及持續監察;及

- 促進與持份者的溝通及交流:定期及有效地與持份者(尤其是內部員工、 AI 供應商、個別消費者及監管機構)聯絡及交流,以提高透明度及建立信任。

根據生產力局調查數據,今年預計將有近一半(49%)香港機構使用 AI,比 2023 數字(30%)升近兩成。鍾麗玲表示,生成式 AI 比其他新興科技如雲端計算、物聯網更具私隱風險,例如訓練 AI 模型時會收集大量資料;使用聊天機器人時,又會將公司機密、客戶資料輸入予機器人,而機器人有機會保存其資料,並用於回應其他使用者的問題。因此建議機構做好風險評估,制定 AI 事故應變計劃以確保 AI 的系統安全及數據安全,定期監察系統及審核,非「做完一次就算」。

鍾麗玲認為框架雖非強制性法律文件,但為機構提供一個合乎道德、負責任、保護私隱的指引使用 AI,有倡導、指引作用。她期望指引有助香港企業或機構運用 AI 時,可以善用之餘,亦能保障個人資料私隱。對於未來會否強制機構跟從框架,鍾麗玲未有正面回應,但表示會在往後將繼續擴大審查使用 AI 的機構,確保機構合乎規範。

資料及圖片來源:香港個人資料私隱公署

想 守 住 企 業 網 絡 安 全 防 線 ?